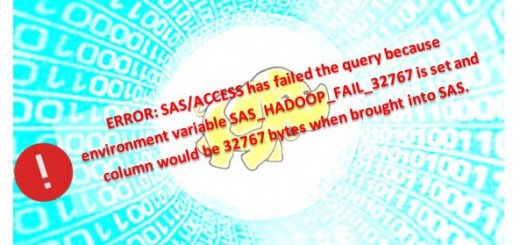

SAS/ACCESS to Hadoop et les champs STRING : WARNING ou ERROR ?

Si vous travaillez avec le module SAS/ACCESS interface to Hadoop et que vos tables HADOOPcontiennent des champs type STRING (qui peuvent contenir jusqu’à 2go de données), vous avez déjà été confronté au problème de...