Les 5 Maillons Faibles de l’IA : Ce que j’ai retenu du Cloud & Cyber Security Expo

L'intelligence artificielle est sur toutes les lèvres, transformant des industries entières à une vitesse fulgurante. Mais à quelle vitesse pensons-nous à sa sécurité ? Mardi 4 juin, j'ai eu la chance d'assister au Tech Show Frankfurt. Mon attention s'est particulièrement portée sur une session de dans le théâtre Cloud AI & Cyber Security.

La présentation, par Daniel Gora, responsable de OWASP Francfort, était intitulée : "How Secure Is Your AI Supply Chain? Spotting backdoors, poisoned data & hidden dependencies". Le titre annonçait la couleur, et la session a tenu toutes ses promesses en offrant une piqûre de rappel nécessaire sur un sujet aussi crucial que complexe.

Le point de départ est simple : des hubs comme Hugging Face et TensorFlow promettent d'accélérer l'innovation. Pourtant, comme l'a souligné Daniel , ils peuvent cacher des portes dérobées (backdoors), des biais et des actes de sabotage purs et simples. Ajoutez à cela des jeux de données publics empoisonnés et des pipelines CI/CD mal configurés, et vous obtenez, selon ses propres termes, un terrain de jeu idéal pour les adversaires.

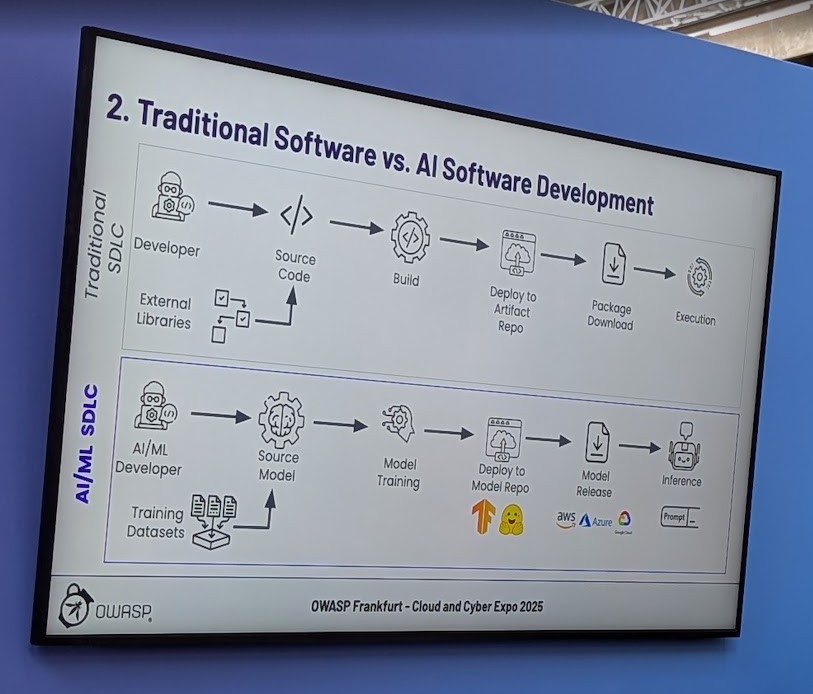

Non, l'IA n'est pas juste un autre logiciel

L'une des premières clarifications essentielles a été de souligner à quel point le cycle de vie du développement de l'IA (AI/ML SDLC) diffère de celui du logiciel traditionnel. Là où nous avons des pratiques de revue de code bien établies, la revue de jeux de données de plusieurs téraoctets est un défi colossal. Là où les cycles de build traditionnels sont rapides, l'entraînement d'un modèle peut être long et extrêmement coûteux. Ces différences créent de nouvelles failles, des angles morts que les attaquants sont prompts à exploiter.

Au cœur du problème : Les 5 maillons faibles de l'écosystème IA

Le cœur de la présentation était ce que j'avais surnommé "The Evil Five", mais que le programme décrit plus formellement comme les cinq maillons faibles de l'écosystème IA actuel.

1. Modèles Manipulés (Manipulated Models)

Il s'agit de la modification de modèles pré-entraînés pour y cacher du code malveillant. Le danger vient souvent de formats de sérialisation non sécurisés, comme le format pickle, qui peuvent exécuter du code arbitraire lors du chargement d'un modèle.

- Prévention : Utiliser des formats plus sûrs comme

safetensorset scanner systématiquement les modèles avec des outils comme ModelScan.

L'appel de Daniel Gora à s'engager au sein de la communauté OWASP résonne plus largement : il est temps pour chaque professionnel de la tech de s'informer, de collaborer et de construire des pratiques de sécurité solides pour que la révolution de l'IA soit une révolution sûre.

2. Empoisonnement des Données (Data Poisoning) C'est la contamination intentionnelle des données d'entraînement pour manipuler le comportement du modèle. L'exemple de "PoisonGPT", où seulement 0,1% de données empoisonnées suffisent à faire propager de fausses nouvelles par un LLM, est terrifiant.

- Prévention : Mettre en place des signatures cryptographiques pour les jeux de données et les modèles, et surveiller en continu les données et les prédictions (les projets comme

sigstoreetSLSAsont des pistes).

3. Pipelines de Déploiement Non Sécurisés (Insecure Model Deployment Pipelines) Les vulnérabilités dans les processus CI/CD (intégration et déploiement continus) permettent l'introduction de modèles corrompus ou l'exécution de code à distance.

- Prévention : Intégrer la vérification des "artefacts" (les modèles eux-mêmes) et une surveillance d'exécution dans les pipelines.

4. Détournement de Paquets et Dépendances Cachées (Package Hijacking) Une menace classique qui prend une nouvelle dimension avec l'IA. Le "typosquatting" ou les attaques par confusion de dépendances peuvent conduire à utiliser un paquet malveillant qui semble légitime, compromettant ainsi tout le projet.

- Prévention : Tenir un inventaire rigoureux des dépendances (un SBOM, ou Software Bill of Materials) et surveiller les activités suspectes.

5. Absence quasi-totale de SBOM pour les modèles (Insufficient Model Provenance) Ne pas savoir d'où vient un modèle, sur quelles données il a été entraîné, et par quelles étapes il est passé, c'est naviguer à l'aveugle. C'est l'un des manques les plus criants de l'écosystème actuel.

- Prévention : Mettre en œuvre un "SBOM" pour les modèles d'IA, documentant leur origine, leurs composants et leur cycle de vie pour garantir l'intégrité.

Une boîte à outils pour agir

La présentation ne s'est pas contentée de dresser un portrait alarmant. Les participants sont repartis avec une "boîte à outils" de vérifications pratiques et de mesures à faible friction pour verrouiller leur chaîne d'approvisionnement en Machine Learning. En quittant le théâtre de la conférence, une chose était claire : sécuriser l'IA n'est pas une option, c'est une nécessité impérieuse. L'appel de Daniel Gora à s'engager au sein de la communauté OWASP résonne plus largement : il est temps pour chaque professionnel de la tech de s'informer, de collaborer et de construire des pratiques de sécurité solides pour que la révolution de l'IA soit une révolution sûre.